在人工智能领域,多模态预训练模型正逐渐成为研究的热点。其中,阿里巴巴达摩院推出的通义万相(ERNIE-ViLG)凭借其强大的跨模态生成能力,吸引了众多研究者和开发者的关注。那么,通义万相究竟是什么?它又是采用何种原理来构建这一多模态预训练模型的呢?接下来,让我们一同深入探索通义万相的奥秘。

一、通义万相概述

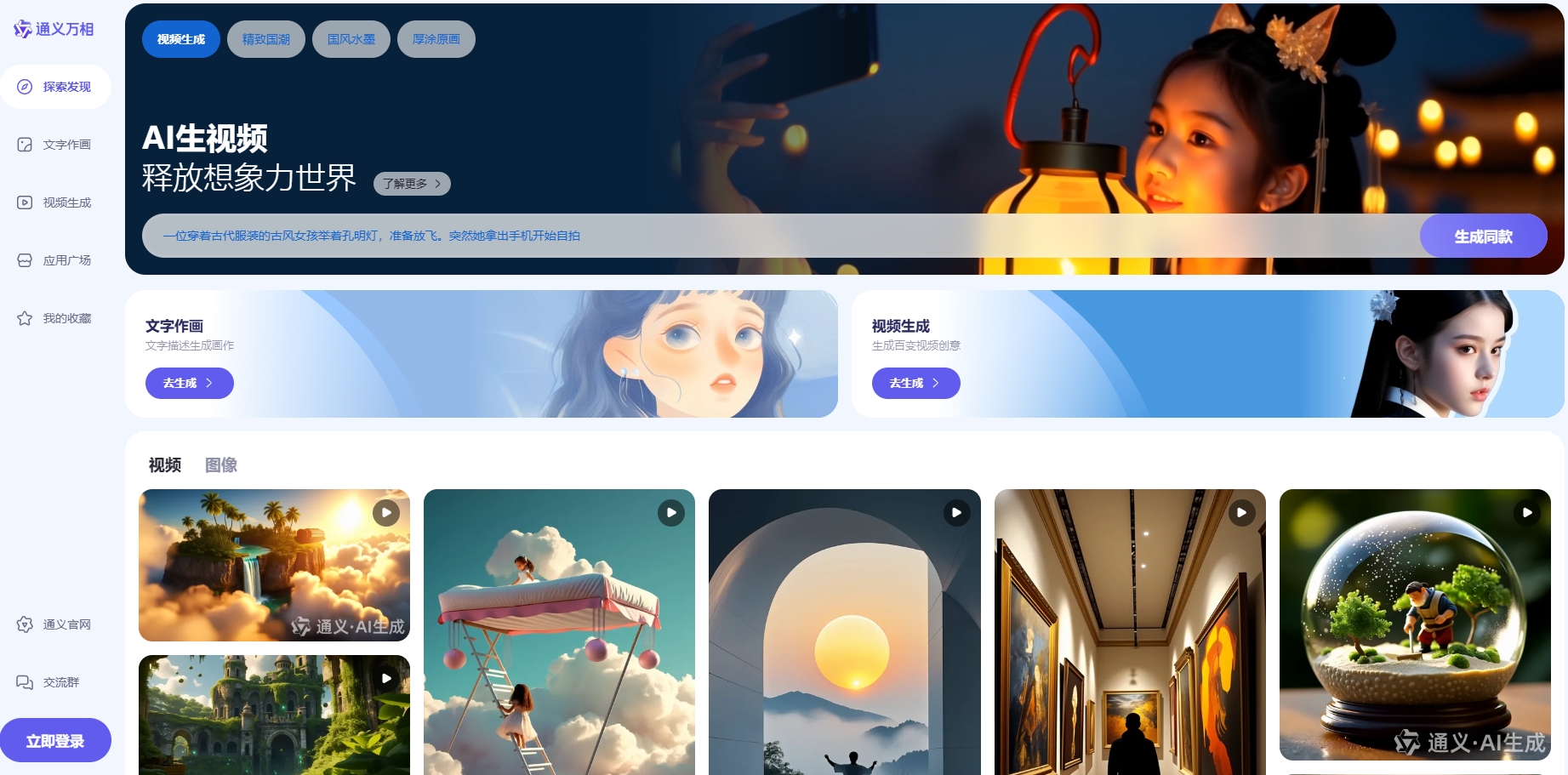

通义万相是阿里巴巴达摩院推出的一款多模态预训练模型,旨在通过跨模态学习,实现文本、图像、声音等多种信息形式的相互转换和生成。该模型在训练过程中,充分利用了大规模多模态数据,学习了丰富的语义和视觉信息,从而能够在不同模态之间建立准确的映射关系。

二、通义万相的构建原理

通义万相的构建原理主要基于深度学习技术,特别是Transformer架构和自注意力机制。以下是对其构建原理的详细解析:

2.1 Transformer架构

Transformer架构是通义万相的核心组成部分。它采用了编码器-解码器的结构,能够处理变长输入和输出,并通过自注意力机制捕捉输入序列中的全局依赖关系。这种架构使得通义万相在处理多模态数据时,能够更好地捕捉不同模态之间的关联信息。

2.2 自注意力机制

自注意力机制是Transformer架构中的关键部分。它通过计算输入序列中每个元素与其他元素之间的相关性得分,来捕捉元素之间的依赖关系。在通义万相中,自注意力机制被用于处理不同模态的数据,使得模型能够学习到跨模态的语义信息。

2.3 多模态数据融合

通义万相在训练过程中,充分利用了大规模多模态数据。这些数据包括文本、图像、声音等多种信息形式。模型通过将这些数据输入到Transformer架构中,实现了跨模态的数据融合。在融合过程中,模型学习到了不同模态之间的关联信息,从而能够在不同模态之间建立准确的映射关系。

2.4 损失函数优化

为了训练出高效、准确的通义万相模型,研究者们采用了多种损失函数进行优化。这些损失函数包括文本生成损失、图像生成损失、跨模态对齐损失等。通过最小化这些损失函数,模型能够学习到更加准确的跨模态映射关系,从而生成高质量的跨模态内容。

三、通义万相的应用场景

通义万相凭借其强大的跨模态生成能力,在多个应用场景中展现出了巨大的潜力。以下是一些典型的应用场景:

3.1 文本生成图像

用户可以通过输入描述性的文本,让通义万相生成与之对应的图像。这种应用可以广泛应用于创意设计、广告制作等领域。

3.2 图像生成文本

通义万相还能够根据输入的图像生成描述性的文本。这种应用可以用于图像识别、自动标注等领域。

3.3 跨模态检索

用户可以通过输入一种模态的信息(如文本),在另一种模态的数据库(如图像库)中检索与之相关的内容。这种应用可以极大地提高信息检索的效率和准确性。

四、通义万相的未来展望

随着人工智能技术的不断发展,通义万相将在未来展现出更加广阔的应用前景。一方面,研究者们将继续优化模型结构和训练算法,提高模型的生成质量和效率;另一方面,通义万相将不断拓展应用场景,为更多领域提供智能化的解决方案。

综上所述,通义万相作为一款多模态预训练模型,凭借其强大的跨模态生成能力和独特的构建原理,在人工智能领域展现出了巨大的潜力和价值。我们相信,在未来的发展中,通义万相将继续引领人工智能技术的潮流,为人类社会带来更多的创新和进步。